とあるところから過去の高層データをちゃんと見ろと

みましたよ~ って言うのもしゃくなので。。 エビデンスを付けてあげようかと。。データをダウンロードしようとしたんですが。。日本の気象データは、いちいち指定してダウンロードしなくちゃ、いけない。。 オープンデータとしては使いにくいです(笑)

気象庁のデータ検索

気象庁の過去データは、ここから取得できます。

http://www.data.jma.go.jp/obd/stats/etrn/index.php

これ、いちいち選択して取得しないといけないんですよねぇ~~ めんどくさい。

一応、こちらからもダウンロードできるサイトもあるんですが。。ダウンロードの容量があったり、データがどこにあるのかわかってないとなかなかダウンロードが難しい。

http://www.data.jma.go.jp/gmd/risk/obsdl/index.php

気象庁のデータをスクレイピング

得意のPython スクレイピングでもしようかな?とふと思ってググったら

https://qiita.com/Cyber_Hacnosuke/items/122cec35d299c4d01f10

このあたりが参考になりそう。。

で。。EXCEL VBAでもやってる人がいて。。

https://qiita.com/6LxAi9GCOmRigUI/items/021c80cb3175dcc2079c

そっか。。Google Sheetでもできるか? そんなに多くもないし。。

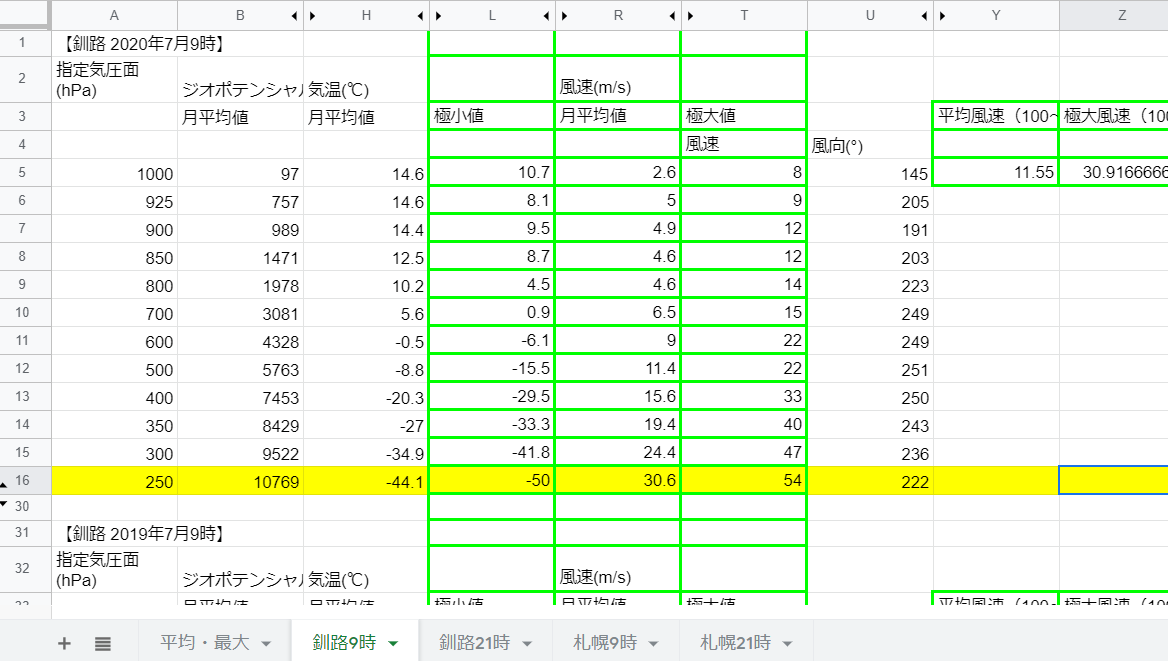

ってことで(笑)さくっと作成。。過去5年分、平均最大。。そして、ある気圧面までの平均とか最大を計算できました。

IMPORTHTML

tableやListが、読み込めます。インポートしたいURLを調査して、Tableだったら、何個目かを調査。。 これはトライアンドエラーしかないのかな?F12を押してもでてこない(笑)

=importhtml(“http://www.data.jma.go.jp/obd/stats/etrn/upper/view/monthly.php?year=2020&month=07&day=1&hour=9&point=47418&atm=&view=”,“table”,4)

URLの中に、いつのどこのデータが欲しいか?を指定できますね。

- year=2020

- month=07

- day=1

- hour=9

- point=47418

高層データの場合、9時21時3時15時しかないですし。。ポイントも少ないですので自由に入れられるわけではありませんし、表示したデータによって、Tableが何個目かも違うので、いちいち確認はいりますが。。Pythonで組むよりは簡単(笑)

変数にしておいて、どんどん自動でとるのもできます。が。。あんまり多いとGoogle君は賢くてゆっくりとってきてくれます(笑)

IMPORTXML

いろいろなデータが読めますが。。XPathで指定したところが読めます。

=importxml(“http://www.data.jma.go.jp/obd/stats/etrn/upper/view/monthly.php?year=2020&month=07&day=1&hour=9&point=47418&atm=&view=”,“/html/body/div[2]/div/div[2]/h3[1]”)

URLは同じですが、XPathの指定が違いますね。

Chromeで開いておいて、みたいURLを開いておいて、F12を押してデベロッパーツールを起動して、①を押しておくと、右と左の画面が連動するので、どこに何のデータが視覚的にわかります。

あとは②、③の手順で、Xpathを取得して、IMPORTXMLにペーストします。

XpathはFull XPathの方で今回は読み込めました。

気象庁ありがとう!

古い形式で取れるので、Pythonでも取得できると、こんな簡単にデータ取得できるので。。気象庁様ありがとうございます。

だれか。。全データスクレイピングして、Githubにでも上げてくれないかな?>おぃ!

そう考えると。。NASAは偉いなぁ。。

https://espoarchive.nasa.gov/archive/browse

コメントを残していただけるとありがたいです