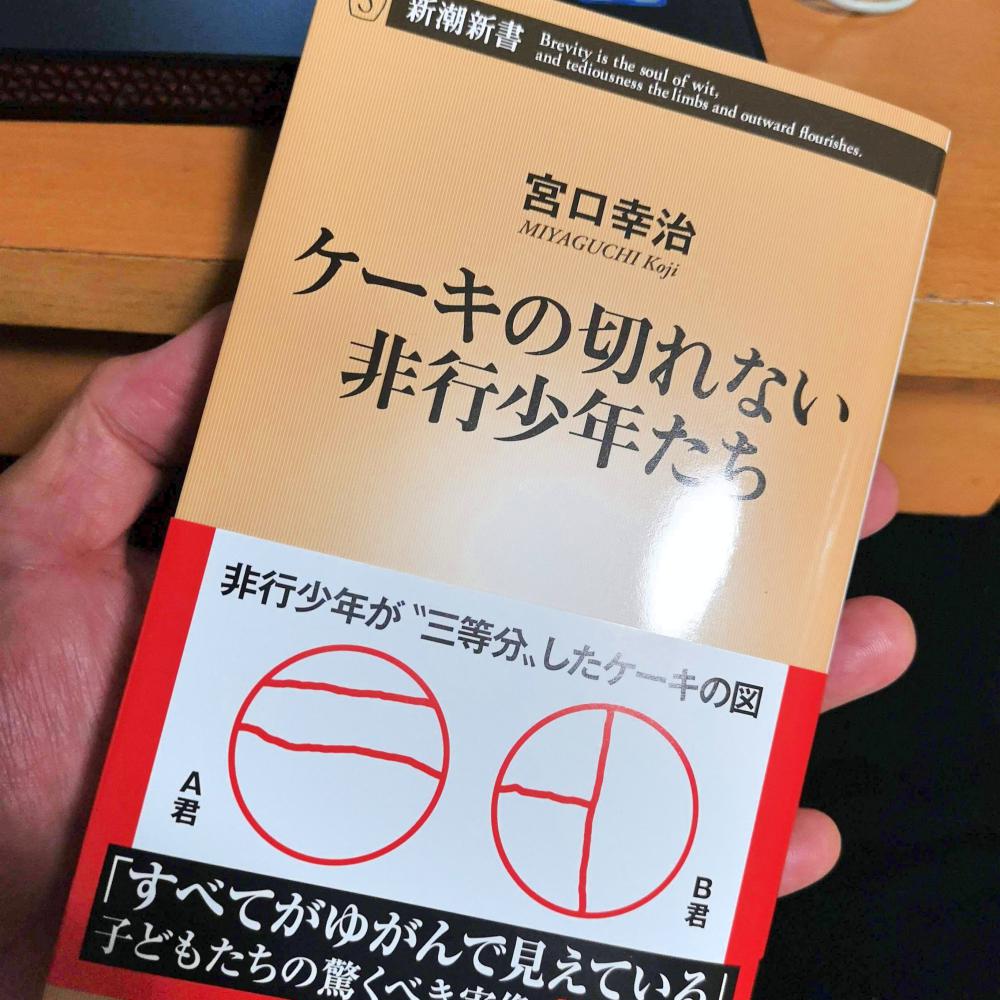

ケーキを切れない非行少年たち

形状を認識できない? 行動の次におこることを予測できない??

確かにあるかも。。って

なんとなく、最近流行りのDeep Learningでも、ある特定の分野で認識が得意なモデルと、そうでないモデルがあったり、CNN(畳み込みニューラルネット)は画像の認識に使われて、RNN(リカーシブニューラルネット)は、言語処理などに使われる。計算の仕組みじたいはあまり変わらないのだけど、そのネットワークモデルの違いで認識に得意不得意があるので。。 ひょっとしたら。。 理解できない犯罪は、いろんなものが認識されないがゆえにおこる犯罪で、AIの研究で、この認識のネットワークモデルが解析されていくと、ひょっとしたら。。なくなるんじゃないかな??

なんて。。思ったので、ふと買ってしまいました。

ヒヤリング結果は沢山

第1章・第2章は、少々驚きです。考えられない人がいるんだな。。と。。

普通に会話自体はできていたりするんだけど、ちょっと複雑なことができない。。次に起こることの予測ができない。形が認識できていない。。

という話が。。

言葉話せるのに。。理解ができてない?????

いやまさに。。。この図みても、僕でも分からないけど(笑)

これは、それぞれの五感の感覚が、生徒全員が同じ時に、見る・聞く だけで学習したことは、他の人でも考えられるって話になるけど、その五感の感覚が、違っていたら、見る・聞くだけの情報では、結果が違うんだと。。。学校教育での話です。まぁ見る・聞くが多いですね。

ん。。。なかなか難しいけど、いいたいことはよくわかる(笑)

要するに、個々の人間で、各センサーの感度も違えば、特性も違う。。 だから、見る聞くだけと、特定の結果を、学習したとして、 次によく似たことを、見る・聞くだけで入力したら、違う結果を生み出しますね。ってことでしょうね。

結論は

コグトレをするといい! ということ。。

コグトレ研究会

認知能力を上げるための教材

これは、ひとつのサンプルですが、形さがし こういう課題を解いていくと、認知力があがるそうです。

確かに。。 認識力あがるでしょうけど。。

なんとなく。。1~4章までに書かれていたことから考えると。。 しっくりこない(笑)

しっくりこないのは??

ひとつは、五感の大切さなのに。。 見る聞く書くトレーニングだということ。。もう少し例えば冷たさを覚えるために川で泳いだり、痛くないのに血が出る現象を田んぼに入ってヒルに噛まれたりして知るとか。。木工やってナイフで指切ってみるとか。。 五感を鍛えなきゃいけないんじゃないかな??って思ったこと。

そして。。

もうひとつは。。 認知能力って。。 ひょっとしたら。。言語を学ぶ前にある程度学習しておかないと、後で学習できるのかな??っていう疑問

目から入ってきたものを認識する

画像認識は、もう本当に、AIというかDeep learningが得意になっていますよね。画像認識でつかわれるのは、CNNというネットワーク構造のモデルです

少し簡単な例ですが、左が、目から入ってきた信号って思ってもらって、右が、その認識されたものを表す言葉と思ってもらうと。。わかりやすいかな? 目から入った信号が、簡単な計算を繰り返すだけで、下の例では1000個のものが認識されたと。。

ImageNet Classification with Deep Convolutional Neural Networks

いろんな画像じゃなくても、手の形状も。。同じような仕組みで認識できるそうです。

Deep Convolutional Neural Network による手形状領域の抽出

こっちは、1万人の顔を識別するというネットワーク

Deep Learning Face Representation from Predicting 10,000 Classes

ちょっと例だけでも、実は、このネットワークというか層が違いますよね。認識率が一番高かったものが、発表されているというのが実態です。学習データの作り方でも大きく違うのですが。。実はこのネットワークの構造というか層の数や、層の中の素子の数で認識率が違うそうなんですよね。

上の例は、AlexNet系の話だったので、8層程度なんですが。。今は、もう152層とかになってる。

AlexNet(8層)~ GoogLeNet(22層)~ ResNet(152層)

で。。何が言いたいかというと、こういう画像認識が、人間の目から脳の間で行われていると仮定すると。。 ここまでに一切言語とか出てこないので、言語獲得以前に行われているのではないか??と。。そうすると、こういう空間認知や形状認識は、それまでにある程度出来上がっていて、これを修正するのは、かなり難しいのではないのかな??と。。

なぜなら、言語を理解できていたら、その言語だけを置き換えた方が学習としては楽だから。。

ちなみに、言語自体も、DeepLearningで自然言語意味理解の方面はかなり進んでいるんですが、これは、RNNというネットワーク構造になってて別物なんですよね。

小脳がCNNとすると、大脳がRNNみたいな感じかな??

この本に書かれていた、言葉はわかるのに。。。 というのは、このCNN部分が形成されていない状態でRNNができてしまっているからかな??と。。

今の僕の知識では、非行少年へのトレーニングは考え付かないのですが。。 CNNの認識とRNNでの認識が引っ付いてきたら。。 なんとなく言語学習が済んだあとでもCNNを矯正することができるんじゃないかな??なんて。。

専門家でないので、よくわからないんですが。。こういう分野が進んでくると、ひょっとしたら、人間の認知能力や形状の認識力を高めるようなことできたりしないかな??

という妄想でした(笑)

ちなみに。。 TensorFlowのサイトひさびさに見たけど。。凄く便利になってる(笑)

チュートリアル

画像認識のチュートリアル

プレイグランド

ちなみに、僕が言っていること、このプレイグランドで、層の数や素子の数を増やしたり減らしたりして、動かしてみるとわかると思います。2次元空間にあるものを二つにわける問題だけど、少し複雑な問題にすると、レイヤーの数が必要になるし、構造を変えると、実はかなり答えが違っていることがわかると思います。

囲み方が違うでしょ。。

ネットワークモデル これGoogle Colabで動くよ。。凄い

コメントを残していただけるとありがたいです